在當今數據驅動的時代,高效、可靠地處理海量信息已成為企業競爭的核心能力。本文將系統性地探討大數據處理的基礎架構、兩種核心數據處理模式(OLTP與OLAP)的區別,并深入解析以數據庫、Hadoop、Spark、Hive及Flink為代表的現代大數據技術生態。

一、 大數據處理的基礎架構

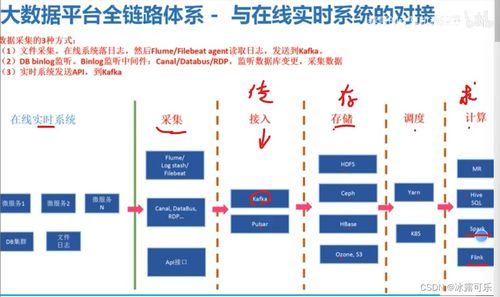

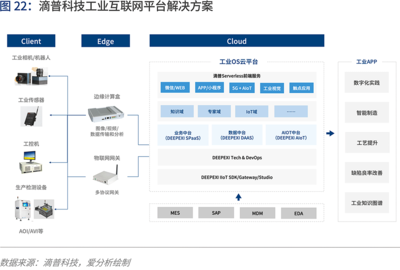

大數據基礎架構是一個復雜的分布式系統集合,其核心目標在于實現對海量、多樣、高速(即大數據的“3V”特性:Volume, Variety, Velocity)數據的存儲、處理和分析。一個典型的大數據技術棧通常包含以下層級:

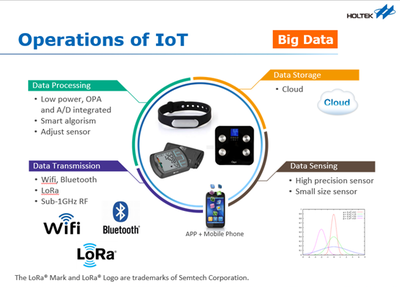

- 數據采集與集成層:負責從各種來源(如日志、傳感器、數據庫、應用程序)實時或批量地采集數據。常用工具有Flume、Kafka、Sqoop等。

- 數據存儲層:提供海量數據的持久化存儲。這既包括傳統的結構化數據存儲(如關系型數據庫),也包括為大規模非結構化或半結構化數據設計的分布式文件系統(如HDFS)和NoSQL數據庫(如HBase、Cassandra)。

- 計算與處理層:這是大數據架構的核心,負責對存儲層的數據進行各種計算。它包括批處理框架(如MapReduce、Spark Core)、流處理框架(如Flink、Storm、Spark Streaming)以及交互式查詢引擎(如Impala、Presto)。

- 資源管理與協調層:為上層應用提供統一的資源調度、作業管理和集群協調服務。YARN(Yet Another Resource Negotiator)是Hadoop生態中的核心資源管理器,而ZooKeeper則提供分布式協調服務。

- 數據查詢與分析層:為用戶和應用程序提供訪問和處理數據的接口,包括SQL-on-Hadoop工具(如Hive)、數據倉庫、OLAP引擎以及各類機器學習庫。

- 數據治理與安全層:確保數據的質量、一致性、安全性和合規性,涉及元數據管理、數據血緣、訪問控制等。

二、 OLTP與OLAP:兩種關鍵的數據處理模式

理解聯機事務處理(OLTP)與聯機分析處理(OLAP)的區別,是設計數據系統的基石。

- OLTP(聯機事務處理):

- 核心目標:支持日常高頻的業務操作,如訂單錄入、銀行轉賬、庫存更新等。強調高并發、低延遲、強一致性的短小事務。

- 數據特征:處理的是最新的、細節性的操作數據,數據量相對較小但更新頻繁。

- 數據庫設計:通常采用規范化的關系模型(第三范式),以最大化數據一致性和減少冗余。

- 典型技術:傳統的關系型數據庫,如MySQL、Oracle、PostgreSQL。

- OLAP(聯機分析處理):

- 核心目標:支持復雜的分析查詢,為商業智能(BI)、數據分析和決策支持服務。強調大數據量的快速、復雜查詢,關注數據的匯總、聚合和多維分析。

- 數據特征:處理的是歷史的、聚合的、來自多個OLTP系統的數據,數據量巨大,但更新不頻繁(批量加載)。

- 數據庫設計:通常采用反規范化的模型,如星型模式或雪花模式,以優化查詢性能。

- 典型技術:數據倉庫(如Teradata)、列式存儲數據庫(如ClickHouse)、以及Hadoop/Spark生態中的分析工具。

核心區別:OLTP是面向“操作”的,確保每筆業務準確無誤地完成;OLAP是面向“分析”的,旨在從海量歷史數據中洞察規律。兩者相輔相成,OLTP系統是數據的“生產者”,而OLAP系統是數據的“消費者”。

三、 現代大數據核心技術與數據處理范式

隨著數據規模與復雜性激增,超越傳統數據庫的大數據技術棧應運而生。

- 數據庫技術的演進:

- 傳統關系型數據庫(RDBMS)仍是OLTP場景的霸主。

- NoSQL數據庫(如MongoDB、Cassandra)為應對非結構化數據、高可擴展性和靈活模式而生。

- NewSQL數據庫(如Google Spanner、TiDB)試圖兼顧SQL的強一致性與NoSQL的橫向擴展能力。

- 云原生數據庫與數據倉庫(如Snowflake、Amazon Redshift)提供了彈性和易用性。

- Hadoop生態:批處理的基石

- Hadoop:一個開源分布式計算框架,核心是HDFS(分布式存儲)和MapReduce(分布式計算模型)。它奠定了低成本、可擴展處理海量數據的基石,但MapReduce編程復雜且延遲高,適合離線批處理。

- Hive:構建在Hadoop之上的數據倉庫工具。它將用戶編寫的類SQL語句(HiveQL)轉換為MapReduce任務執行,大大降低了大數據分析的門檻,是早期進行大規模批處理分析的關鍵組件。

- Spark:統一計算引擎的革新

- Spark:一個基于內存的統一分布式計算引擎。它通過引入彈性分布式數據集(RDD)及更高級的DAG執行引擎,比MapReduce快數十到數百倍。

- 核心優勢:提供了統一的編程模型(Spark Core),可同時支持批處理、交互式查詢(Spark SQL)、流處理(Structured Streaming)、機器學習(MLlib)和圖計算(GraphX),實現了“一棧式”解決方案。

- Flink:流處理為先的架構

- Flink:一個真正的流處理引擎,采用“流是本質,批是特例”的設計哲學。其核心是分布式數據流引擎。

- 核心優勢:提供高吞吐、低延遲、Exactly-Once語義的流處理能力。其批處理被視為有界流來處理。Flink在復雜的事件驅動型應用和實時數據分析場景中表現卓越,與Spark Structured Streaming形成競爭。

四、 技術選型與融合趨勢

選擇合適的技術取決于具體的業務需求:

- 高頻事務操作:首選OLTP關系型數據庫或NewSQL。

- 離線大數據分析、歷史報表:Hive on Hadoop/Spark 仍是可靠選擇。

- 需要融合批處理、交互查詢和機器學習的復雜分析:Spark生態是強大的一體化平臺。

- 對延遲極其敏感的實時監控、實時風控、CEP(復雜事件處理):Flink是當今的業界標桿。

現代大數據架構正朝著流批一體和湖倉一體的方向演進。例如,Spark和Flink都在努力統一流和批的編程模型;而將數據湖的靈活性與數據倉庫的管理性能相結合的架構,正成為企業數據平臺的新標準。理解這些基礎架構、模式與技術的差異與聯系,是構建高效、面向未來數據系統的關鍵第一步。